大規模言語モデル(LLM)の推論能力向上のためにトークン数を増やせば良いという常識が覆されました。Microsoft Researchが発表した最新研究は、AIの推論効率に関する新たな視点を提供し、私たちのAI活用戦略を根本から見直すきっかけになるかもしれません。より多くが必ずしも良くない理由とは何でしょうか。

ARCHETYP Staffingでは現在クリエイターを募集しています。

エンジニア、デザイナー、ディレクター以外に、生成AI人材など幅広い職種を募集していますのでぜひチェックしてみてください!

ボタンから募集中の求人一覧ページに移動できます。

思い込みを覆す研究結果:トークン数増加の落とし穴

参照:Venture Beat

Microsoft Researchが発表した最新の研究は、これまでの常識を覆す重大な発見です。彼らは9つの最先端基盤モデルを対象に、GPT-4o、Claude 3.5 Sonnet、Gemini 2.0 Proといった「従来型」モデルと、OpenAIのo1、AnthropicのClaude 3.7 Sonnetのような推論強化モデルについて徹底的な検証を行いました。この研究の中心にあるのが「推論時スケーリング」という技術です。これは、AIが答えを出す際に計算リソースをどれだけ投入するかを調整するもので、今までは「より多くのリソースを使えば、より良い結果が得られる」と信じられてきました。しかし実際には、そうとは限らないことが明らかになったのです。

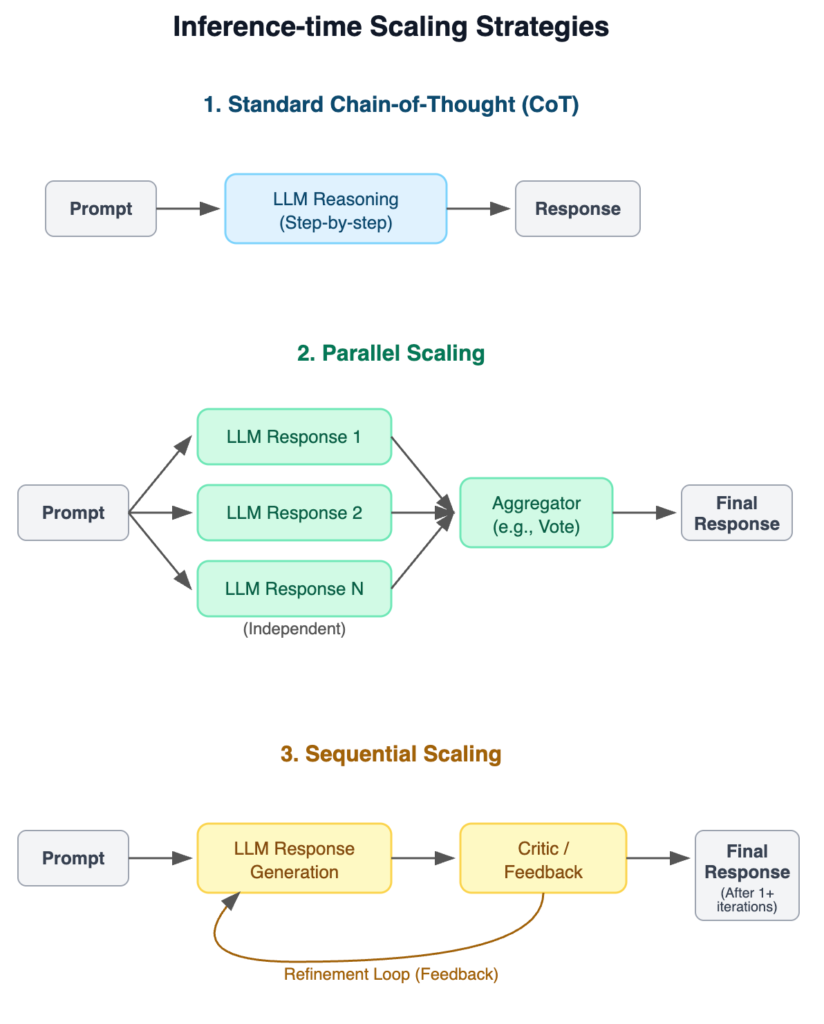

研究チームは3つの異なるアプローチでモデルを評価しました。まず「標準的な思考連鎖(CoT)」。これはモデルがステップバイステップで考えるよう指示する基本的な方法です。次に「並列スケーリング」。同じ質問に対して複数の独立した回答を生成し、最良のものを選ぶ手法です。そして「逐次スケーリング」。モデル自身が回答を評価し改良していくプロセスです。(上記の表に各モデルのイメージ画を添付)

彼らはこれらのアプローチを、数学とSTEM推論(科学・技術・工学・数学の分野における論理的思考能力)、カレンダー計画(日程調整や予定管理などの時間に関わる計画立案)、NP困難問題(計算量理論において、効率的な解法が見つかっていない複雑な問題群)など8つの異なるタスク群で検証しました。特に重要なのは、問題の難易度によるパフォーマンスの変化も分析できたことです。

驚くべきことに、より長い思考プロセス(より多くのトークン)が必ずしも正確性向上につながらないケースが多数見つかりました。むしろある場合では、それがモデルが苦戦している証拠になっていたのです。例えば、AIME 2025数学ベンチマークでは、DeepSeek-R1はClaude 3.7 Sonnetと比較して、ほぼ同じ精度でありながら5倍以上のトークンを消費していました。つまり、より少ないリソースで同等の結果を出せるモデルもあるということです。

また、特に注目すべき点として、トークン消費の高い変動性が明らかになりました。同じモデルに同じ質問を繰り返し投げかけても、使用されるトークン数は大きく変わることがあります。これはモデルが同じ正解にたどり着くまでの思考経路が毎回異なっていることを示しています。まるで人間が同じ問題を解く時に、ある日はスムーズに解けるのに、別の日には回り道をしてしまうようなものではないでしょうか。

この発見は、私たちがAIモデルを選ぶ際の新たな視点を提供してくれます。単に最新のモデルを選ぶのではなく、タスクの性質や複雑さに適したモデルを選ぶことが重要なのです。

次のセクションでは、こうした知見をどのように実践に活かせるのかを見ていきましょう。

AI活用の新しい常識:効率と信頼性の両立

Microsoft Researchの発見から浮かび上がったのは、AI活用における「コスト非決定性」という新たな課題です。同じ質問を繰り返しても、使用するトークン数(つまりコスト)が大きく変動するため、企業の予算計画が困難になります。Microsoft Researchのシニアプリンシパルリサーチマネージャーであるベスミラ・ヌシュ氏は「開発者とユーザーは、コスト予測のためにトークン使用量の標準偏差が低いモデルを好む」と指摘しています。

興味深い発見として、単純なタスクでは従来型モデルでも推論呼び出しを大幅に増やすことで(最大50倍)推論モデルに近いパフォーマンスが得られることもありました。しかし複雑なタスクでは、この「ブルートフォース」アプローチの効果は薄れていきます。つまり、タスクの複雑さによって最適なアプローチが変わるということです。

実践的な知見として、Microsoft Researchは「モデルのプロファイリング」の重要性を強調しています。ヌシュ氏によれば、「プロファイリングは、どのモデルの変動性が低いかを選択するツールとして開発者にとって有用」とのことです。これはつまり、タスクごとに最適なモデルを見極めることが効率と信頼性の両立には不可欠だということです。もう一つ注目すべきは、「完璧な検証機」がパフォーマンスを向上させたという点です。例えば数学的な問題では、約11,000トークン長を超える回答は正解の可能性が低く、そこで生成を中断するか修正する方が効率的です。この発見は、AIシステムに検証メカニズムを組み込むことの重要性を示しています。

将来的には、既存の検証技術(SATソルバーやロジスティック有効性チェッカーなど)とAIインターフェースの組み合わせが課題になると研究者たちは予測しています。ヌシュ氏によれば、「ユーザーが常に形式的な方法でクエリを定式化するわけではなく、自然言語インターフェースを使用し、同様の形式または最終的なアクションで解決策を期待する」ため、両者の接続が重要になるとのことです。こうした知見は、私たちがAIをより効果的に活用するための道標となるでしょう。

まとめ

いかがだったでしょうか?

Microsoft Researchの研究は、AIの世界における「多ければ良い」という常識に疑問を投げかけました。より多くのトークンや計算リソースを投入することが、必ずしも良い結果をもたらすとは限らないのです。この発見は、AIを活用する私たち全員にとって重要な教訓となります。効率と信頼性を両立させるためには、タスクの性質を理解し、適切なモデルを選択することが鍵となるでしょう。それこそが、これからのAI活用における新しい常識なのです。

ARCHETYP Staffingではクリエイターを募集しています!

私たちはお客様の課題を解決するweb制作会社です。現在webサイト制作以外にも、動画編集者や生成AI人材など幅広い職種を募集していますのでぜひチェックしてみてください!

また、アーキタイプではスタッフ1人1人が「AI脳を持ったクリエイター集団」としてこれからもクライアントへのサービス向上を図り、事業会社の生成AI利活用の支援及び、業界全体の生成AIリテラシー向上に貢献していきます。

生成AIの活用方法がわからない、セミナーを開催してほしい、業務を効率化させたいなどご相談ベースからお気軽にお問い合わせください!

ボタンから募集中の求人一覧ページに移動できます。